開発者の皆さん、こんにちは!

📣 第2回 InterSystems Japan 技術文書ライティングコンテストの勝者が決定しましたので、発表します!📣

.png)

🥇 1位 - @Saori Murata さんが投稿された「IRIS環境設定の自動化について~インストールマニフェストの利用~」

以下賞品の中からお好きな1点をお選びいただけます。

- Apple Watch SE (第二世代, 2023)

- SanDisk エクストリーム ポータブルSSD V2 外付け 2TB

- Apple AirPods(第3世代)

🥈2位 - @So Ochi さんが投稿された「IRIS開発における生成AIの活用について」

以下賞品の中からお好きな1点をお選びいただけます。

- ソーダストリーム Genesis Deluxe v2(ジェネシス デラックス) スターターキット

- moonka デジタルフォトフレーム 10.1インチ wifi 人感センサー 1280*800 32GBストレージ内蔵 タッチパネル

- moonmoon トトノエライト 光 目覚まし時計 (トトノエライトプレーン)

🥉 3位 - @Kawasaki Kazuhito さんが投稿された「SourceControlを用いた自動ソースチェックツールについて」

以下賞品の中からお好きな1点をお選びいただけます。

- 【温熱&加圧】ホットアイマスク<EYE RELAX>

- スタバギフトカード(5000円分)

- パナソニック 頭皮エステ 皮脂洗浄タイプ シルバー EH-HM7A-S

🌟 参加賞 - 投稿者全員

(今回のコンテストは賞品を選択式にしてみました。1位の方は1~3位の賞品を、2位の方は2~3位の賞品をお選びいただけます。)

受賞者の皆さん、おめでとうございます!🎊 またコンテストへチャレンジいただきありがとうございます!

コンテスト表彰式は、11月8日開催のミートアップ第2部の中で行います。ご都合よろしければぜひご参加ください!

(各順位の賞品も表彰式の中でご選択いただく予定です。)

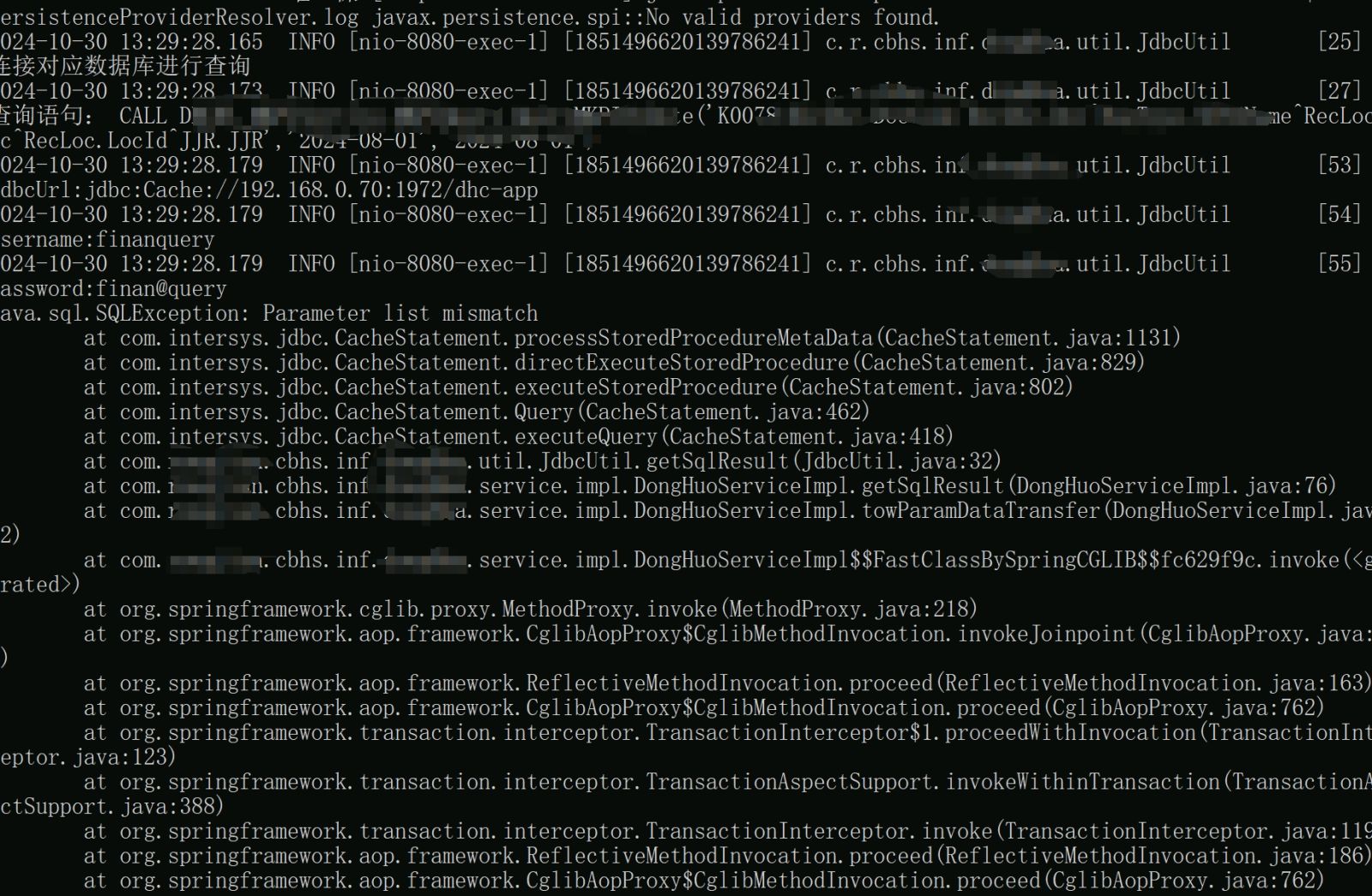

さて、投票結果の得点内訳ですが、コミュニティメンバーからの「いいね」の数とエキスパート得点(審査員:インターシステムズ社員投票+ボーナス得点)の合計得点での結果となります。

🥉3位が接戦でしたので、以下得点詳細をお知らせします。

| 記事 | いいね | エキスパート得点 | 合計 |

| IRIS環境設定の自動化について~インストールマニフェストの利用~ | 24 | 21 | 45 |

| IRIS開発における生成AIの活用について | 12 | 30 | 42 |

| SourceControlを用いた自動ソースチェックツールについて | 15 | 17 | 32 |

| UnitTest(ユニットテスト)の自動化について考察 | 11 | 20 | 31 |

| FHIR Object Modelを使ったInteroperability開 | 8 | 22 | 30 |

| Embedded Python を利用する時の注意点 | 6 | 7 | 13 |

コンテストへ記事を投稿いただいた、 @Saori Murata さん @So Ochi さん @Kawasaki Kazuhito さん @Yusuke Kojima さん @Kosaku Ikeda さん @Akio Hashimoto さん、素晴らしい内容をコミュニティメンバーに共有してくださりありがとうございました!

また、いいねで記事を応援してくださったコミュニティメンバーの皆様、ありがとうございました!

日本、アメリカ、中国、etc..国を問わずインターシステムズ開発者コミュニティのコンテストはどこかで何かを開催しております。最近ではコンテスト以外にもアイデアを出し合うアイデアソン、コーディングではなくウォーキングにチャレンジするウォーキングチャレンジなども開催しています。

コミュニティメンバーの方ならどなたでもご参加いただけます。各国のコミュニティページもぜひ、覗いてみてください👀

今後も日本独自のコンテストを企画できたら!と思っておりますので、ぜひコミュニティのお知らせ記事に今後もご注目ください!

.png)